问题分诊室

从DeepSeek技术看通用人工智能发展趋势

发布时间: 2025-04-30

近年来,随着深度学习技术的快速发展,大语言模型(LLMs)在自然语言处理、内容生成、推理能力等方面取得了显著进展。然而,尽管这些大模型在规模和性能上不断突破,其发展仍面临诸多挑战,包括高昂的训练成本、推理效率的瓶颈,以及模型在复杂任务中的逻辑推理能力不足等问题。在此背景下,DeepSeek应运而生,作为中国在通用人工智能(AGI)领域的重要探索,DeepSeek不仅继承了现有大模型的优势,还在模型架构、训练效率和推理能力等方面进行了创新性突破。

1、DeepSeek-V3的创新架构和低成本高性能训练方法

传统的大型模型训练,无论是闭源的GPT系列还是开源的LLaMA系列,都面临着巨大的图形处理器(GPU)资源消耗的挑战。然而,DeepSeek-V3模型以其创新的设计理念,巧妙地实现了低成本与高性能的完美融合,为这一难题提供了突破性的解决方案。该模型不仅显著提升了推理效率,还有效优化了资源利用率,为大规模模型训练开辟了新的道路。

DeepSeek通过创新性采用FP8混合精度训练框架,实现了大模型算法与智能硬件的高度协同优化,这一技术路径对推动中国AI基础设施自主化,实现基于国产软硬件的协同优化设计具有重要启示。

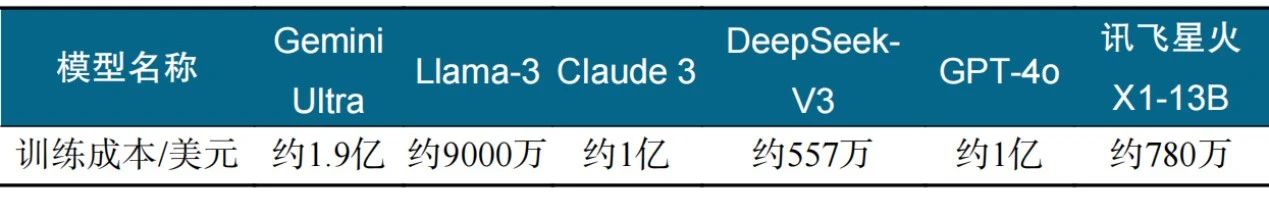

DeepSeek-V3以高达671 B(6710亿)的参数量,将训练成本大幅降低至约557万美元(表1),与传统大模型动辄上亿美元的投入形成鲜明对比。这一突破不仅彰显了DeepSeek的技术实力,更为行业提供了高效、经济的训练范式。

表1 各种大模型训练成本对比

2、DeepSeek-R1提升“慢思考”的认知推理能力

在人工智能领域,认知推理能力是衡量模型智能水平的重要指标之一。DeepSeek-R1通过创新的推理技术和架构设计(图1),显著提升了“慢思考”能力——即系统化、逻辑化的深度推理能力。

图1 DeepSeek强化学习训练流程

2.1 DeepSeek-R1推理技术简述

DeepSeek-R1-Zero使用准确度奖励和格式奖励来指导模型推理的强化训练,尽管其推理表现尚不如其他模型,但通过生成中间思维步骤,成功展示了推理能力生成的可行性。DeepSeek-R1进一步通过结合监督微调与强化学习来优化其推理性能。通过采用监督微调和强化学习技术,DeepSeek有效规避了PRM技术中依赖高质量的人工标注数据、难以明确定义细粒度步骤以及判断中间步骤正确性等关键问题,显著提升了模型在复杂推理任务中的性能表现。

2.2 基于神经符号系统的推理架构

DeepSeek-R1和OpenAI o1/o3这些大模型系统所取得的推理性能,标志着LLMs在推理方面的研究取得了新的突破,开启了这个领域的新范式,即系统1(“快思考”)+系统2(“慢思考”)。这个范式意味要对符号主义积累的成果和现有的大模型框架进行更深入的结合,可以在不同的情境中形成动态可变的、复杂思维链,以便在常识推理、数学推理、算法推理、科学推理、具身推理等方面持续提升,直至达到甚至超过人类的认知推理能力。

大模型虽然在各种自然语言问题的基准测试(benchmark)中表现不错,但是在真实的交互中,经常出现“幻觉”问题。DeepSeek-R1代表的强化推理能力,未来有望让大模型能够在合适的事实性和逻辑性约束的奖励函数限制下,通过自我反思和思维链回溯,大大减少自我幻觉的产生,更好地提升常识推理能力。数学推理是目前LLMs研究者都高度关注的领域,充分体现了神经符号融合的技术内涵。DeepSeek就有专门针对数学的模型版本:DeepSeekMath 7B和DeepSeek-Prover-V1.5。

前文论述的DeepSeek和其他推理系统所构造出的神经符号系统,为未来实现跨领域、超长链条的科学推理提供了很有价值的探索思路。未来,基于类似DeepSeek-R1的推理技术,可以从多个方面赋能跨领域的科学推理,从而突破费曼极限。首先,可以在海量科技文献的基础上,实现最新学科知识的深度整合和挖掘,形成对复杂科学领域探索的知识基础。其次,可以在海量科学数据的基础上,对这些数据蕴含的内在规律和模式进行分析,归纳总结出本质的科学规律,建立融合神经网络和数理机理符号的新型科学模型,来刻画和表征复杂系统的关键因素,理解复杂系统要素之间的深层次关系,突破传统模型无法领悟的因果链条。

3、通用人工智能的未来趋势

DeepSeek的成功开启了通用人工智能深度探索的新篇章,特别是对大语言模型、多模态大模型和具身智能大模型的发展带来新的动力。为推动人工智能技术的持续演进,亟需深入探讨以下3个关键问题:首先,DeepSeek所采用的开源路线将在通用人工智能的发展中扮演何种角色?其次,在迈向通用人工智能的过程中,Neural Scaling Law是否仍具备其理论指导意义?最后,如何通过“通专结合”的方式构建行业大模型,从而充分发挥大模型技术在产业应用中的价值?

3.1 开源开放生态对发展通用人工智能的作用

DeepSeek的成功本质上体现了开源路线在推动生成式人工智能技术进步中的重要作用。DeepSeek-R1系统超过了o1模型的性能,无疑给开源大模型社区提供了全新的技术选择,打破了OpenAI的技术垄断,让每个研究者和开发者都能站在这个全新的起点上,以开源进化的技术演进模式,持续加速探索LLMs推理的新思路和新创新。DeepSeek的开源实践或许印证了发展通用人工智能的必然规律,必须通过开放的技术创新生态,打造开放的通用人工智能系统,实现开源创新驱动、模型滥用风险防范、可持续商业模式之间的微妙平衡。

3.2 Neural Scaling Law对通用人工智能发展的影响

在大模型研发中,通常认为模型的性能提升和模型参数规模之间满足幂律关系,也就是Neural Scaling Law,即模型规模越大,输入的训练数据越多,模型预测能力就越强。但这种指数级增长的算力需求,给智算集群系统带来了极大的开销,使得规模的可持续扩展遇到瓶颈。此外,高质量和高密度数据语料库的稀缺性也成为制约模型规模扩展的关键因素。综上所述,单纯依赖模型规模的扩展来实现通用人工智能,无论在技术可行性还是经济成本方面,均难以构成可持续的技术路径。

目前,业界的研究重点正在转向后训练(Post-Training)和测试时间缩放(Test-Time Scaling,TTS)2个方面。1)监督微调和强化学习等Post-Training方式成为优化模型性能的关键手段。2)TTS是一种在推理阶段通过增加计算资源或时间来提升大模型性能的技术。未来的研究将更加注重模型的高效性和可持续性,而非单纯追求规模的扩展。

3.3 “通专结合”的行业模型

随着大模型训练范式的改变,尤其是推理和Post-Training、TestTime Scaling逐渐成为发展的热点。在垂直领域走“通专结合”的技术路线成为必然,需要引入模块化的架构假设、强化式的能力提升,支持大模型与业务逻辑的紧密结合,在产业领域实现广泛落地与价值赋能。首先,巨无霸式的通用模型必然给企业带来维护升级、训练成本等一系列的复杂性难题,必须引入模块化设计的理念,实现模型结构和业务功能的松耦合架构。其次,业务场景需要对基座模型进行定向的蒸馏与微调,以提升其专业能力。

自DeepSeek大模型发布以来,已在多个行业,尤其是保险领域,取得了显著的应用成效。截至2025年2月18日,已有多家领先保险公司接入DeepSeek并落地应用。这种“通专结合”的模式不仅促进了大模型的落地应用,更推动了行业智能化的全面升级。

4、结论

DeepSeek的推出标志着中国在通用人工智能领域迈出了重要的一步,开启了基于国产技术的人工智能创新生态新篇章。通过在大语言模型、推理技术等方面的创新,DeepSeek不仅展示了其在多领域对话、内容生成以及深度逻辑推理方面的强大能力,还为未来通用人工智能的发展提供了新的思路和方向。DeepSeek的成功不仅为开源生态注入了新的活力,也为行业模型的“通专结合”提供了可行的路径。随着模型规模的扩展和推理技术的不断优化,DeepSeek有望在更多垂直领域实现广泛应用,推动人工智能技术在医疗、教育、金融等行业的深度落地。

总的来说,DeepSeek不仅是中国人工智能技术发展的里程碑,更是全球人工智能领域的重要贡献者。随着AI技术的不断进步和应用的深入,像DeepSeek一样的中国自主AI研究力量有望在更多领域引领原创技术突破,推动人工智能迈向新的高度,为人类社会可持续发展带来更多的创新与变革。

本文作者:吴文峻、廖星创、赵金琨

作者简介:吴文峻,北京航空航天大学复杂关键软件环境全国重点实验室,杭州市北京航空航天大学国际创新研究院,教授,研究方向为可信智能、群体智能、AI for Science。

文章来源:吴文峻, 廖星创, 赵金琨. DeepSeek技术创新与通用人工智能发展趋势[J]. 科技导报, 2025, 43(6): 14-20.